1. 概率基础¶

广义线性模型的理论大量依赖概率论的知识,因此本章先回顾一下概率论的一些基础知识。 为了帮助非数学专业的读者更容易理解和入门, 本章乃至本书都是采用大白话的方式进行讲解, 并不追求严谨的学术定义,所以一些描述可能并不严谨。

1.1. 概率模型¶

在日常生活中,经常会遇到某些”事情”的结果是不确定的, 比如投掷一枚硬币,其结果可能正面朝上,也可能反面朝上,更有可能是立着。 一般来说,如果一件”事情”的结果是不确定的,那么就意味着这件”事情”多个可能的结果。 反过来,如果一件”事情”只有一种结果,那么这个结果的发生就是必然的,这样的”事情”的结果就是确定性的。 通常可以把”事情”的结果具有不确定性的现象,称为 随机现象。 比如投硬币、掷骰子等。

一个具有不确定性的”事情”,其结果的发生具有随机性。 那么每种结果发生的”可能性”是多少呢?能否具体的量化出来呢? 如果可以把每种结果的可能性量化出来,就可以帮助我们对结果进行预判。 最典型的例子就是赌博,投掷一枚骰子的结果是随机的,如果能清楚的知道每个点数的可能性的大小, 就可以一直押注最大可能性的点数,这样就稳赚不赔了。

1.1.1. 概率律¶

概率模型 就是对不确定现象的数学描述,每种可能结果发生的可能性的量化结果就是 概率律。 比如正常的投掷一枚正常的硬币,其结果是正面向上的概率是 \(0.5\) ,反面向上的概率也是 \(0.5\) ,至于立起来的结果,我们认为其几乎不可能发生,因此立起来的概率是 \(0\) 。 概率值越大,意味其发生的可能性越大。

我们可以把每一个概率模型都关联着一个 试验, 试验的所有可能结果和这个概率模型的所有结果一一对应,该试验的所有可能结果就构成 样本空间, 用 \(\Omega\) 表示样本空间,样本空间的子集称之为 随机事件,通常用大写的字母表示随机事件。

我们以掷骰子为例,一个六面体的骰子,把投掷骰子的行为定义为试验,投掷的结果有六种可能, 这六种结果就构成了样本空间 \(\Omega\) ,空间 \(\Omega\) 中有六个样本点, 点数为 \(1\) 的样本点(结果)就是一个 随机事件, 同样点数为 \(2\) 的样本点(结果)也是一个 随机事件。 以此类推,样本空间 \(\Omega\) 中的每一个样本点都可以看做是一个随机事件, 随机事件的结果可以是发生,也可以是不发生。

随机事件 是一个随机试验的样本空间的 子集 , 注意,这里是子集,而不是单个样本点。 子集是样本点的集合,可以包含多个样本点。 比如掷骰子的试验,其样本空间为 \(\Omega=\{1,2,3,4,5,6\}\) ,样本空集的一个子集 \(A=\{1,3,5\}\) , 可以描述成”结果为单数的随机事件”, 与之对应的另一个随机事件就是”结果为偶数” 。再比如,可以定义一个 “结果为 \(1\) 或 \(2\) ” 的随机事件。 原则上对于随机事件的定义(子集的划分)没有限制, 但是,一个样本空间的多个随机事件必须是互斥的 。像”结果是 \(1\) 或者 \(3\) “与”结果是 \(1\) 或者 \(4\) “, 这样两个事件是不允许的, 因为它们两个存在交集 \(1\) 。 并且,一个样本空间中所有事件的并集,是这个样本空间全部的样本点。

概率 是对一个随机事件发生的可能性的量化结果, 对概率最直观的理解是 频率 。 在重复进行多次互不影响试验的结果中,事件发生的频率就可以看做是这个事件发生的概率。 随机事件 \(A\) 的概率记作 \(P(A)\) 。

比如投掷骰子的试验,假设重复进行 \(N\) 次,点数为 \(1\) 的事件发生了 \(n_1\) 次 ,点数为 \(2\) 的事件发生了 \(n_2\) 次, 以此类推,点数为 \(i\) 的事件发生了 \(n_i\) 次。 则有,\(N=n_1+n_2+n_3+n_4+n_5+n_6\) 。 其中每个点数发生的频次(数)是 \(n_i\) ,发生的 频率 是 \(\frac{n_i}{N}\) 。 则点数为 \(1\) 的事件发生概率为 \(P(1)=\frac{n_1}{N}\) ,同理,点数为 \(i\) 的事件发生概率为 \(P(i)=\frac{n_i}{N}\) 。

按照 概率=频率 的定义, 概率自然也符合频率的一些特性。 比如频率一定是正数,并且频率是大于等于 \(0\) 小于等于 \(1\) 的, 并且,同一个样本空间中,所有随机事件发生的频率之和为 \(1\) ,这是因为所有事件发生的频次相加就等于试验总次数。

假定我们已经确定了样本空间 \(\Omega\) 以及与之关联的试验, 概率律 确定了任何结果或者任何结果的集合(称为随机事件)的似然(可能性)程度。 更精确一点的说,它给每一个事件 \(A\) ,确定一个数 \(P(A)\), 称为事件 \(A\) 的概率, 概率律需要满足下面几条公理。

1.1.2. 离散模型¶

当样本空间由有限个样本点组成时,称之为离散模型。 假设一个离散样本空间 \(\Omega=\{\omega_1,\omega_2,\cdots,\omega_N \}\) ,其含有 \(N\) 个样本点,\(N\) 是有限的, 定义在这个样本空间的随机事件集合为 \(S=\{s_1,s_2,\cdots,s_N \}\)。 假设随机事件集合 \(S\) 和样本空间 \(\Omega\) 是一一对应的, 即事件 \(s_i\) 表示实验结果是样本点 \(\omega_i\) 。 则事件 \(s_i\) 发生的概率为

并且,事件 \(\{s_1,s_2,\cdots,s_N\}\) 的概率是 \(P(s_i)\) 之和。

1.1.3. 连续模型¶

若样本空间是一个连续值集合,称之为连续模型,此时样本点的数量是无限的。 连续值模型和离散模型有很大的不同, 在连续值模型中,由于样本点的数量是无限的, 如果单个样本点的概率为正数,则所有样本点的概率之和将无穷大,这显然是不行的。 因此我们将连续值模型中,单个样本点的概率定义为 \(0\) 。那要如何表示连续值模型的概率呢?

连续值模型的样本空间是一段连续值的区间,我们可以把这个区间分给成一份一份的, 然后定义每一份的概率就是这一份的长度和整个区间长度的比值。 比如,在赌场中有一种幸运大转盘的赌具,假设这个圆盘被分割成 \(12\) 个扇形, 转动圆盘,当圆盘停止时,指针指向哪个区域,就表示这个区域所代表的事件发生了。 如果圆盘是被等分成 \(12\) 份,则指针落在每个区域的概率都是 \(1/12\) 。

显然,如果样本空间是一个一维空间,则可以划分成一个个的线段, 每个线段可以代表一个事件,事件的发生概率就是线段长度和样本空间总长度的比值。 如果样本空间是一个二维平面空间,则可以划分成一个个子平面, 每个子平面代表一个事件,事件的发生概率就是子平面的面积和样本空间总面积的比值。 以此可以类推更高维的空间。

连续概率模型的计算,就是把整个样本空间分割成子区间,每个子区间的概率值就是这个子区间和整个样本空间的比值。 显然通过这样的定义得到的概率律,也是符合概率的三个公理的。 本质上就是把连续值区间离散化了。

1.2. 条件概率¶

条件概率是给定 部分信息 的基础上对实验结果的一种推断。例如 在连续两次抛掷骰子的试验中,已知两次抛掷的点数的总和为 \(9\),第一次抛掷的点数为 \(6\) 的可能性有多大。 换句话说,假设我们已经知道给定的事件 \(B\) 发生了,而希望知道令一个给定事件 \(A\) 发生的可能性。 此时,我们需要构建一个新的概率律,它顾及了事件 \(B\) 已经发生的信息,求出任何事件 \(A\) 发生的概率。 这个概率就是给定 \(B\) 发生之后事件 \(A\) 的 条件概率 , 记作 \(P(A|B)\) ,读作 \(B\) 的条件下 \(A\) 的概率。 当然,条件概率也必须符合三条概率公理。 我们用实际的例子来说明条件概率。

假设投掷硬币的结果组成样本空间 \(\Omega_{\text{币}} = \{\text{正},\text{反}\}\), 正面向上的结果定义为事件 \(B_{\text{正}}\) ,反面向上的结果定义为事件 \(B_{\text{反}}\) 。 取出球的颜色组成的样本空间为 \(\Omega_{\text{球}} = \{\text{红},\text{白}\}\), 定义红色的结果为事件 \(A_{\text{红}}\), 白色的结果为事件 \(A_{\text{白}}\) 。

已知事件 \(B_{\text{正}}\) 发生的情况下,事件 \(A_{\text{红}}\) 发生的概率,就是条件概率 \(P(A_{\text{红}}|B_{\text{正}})=4/10=0.4\)。

已知事件 \(B_{\text{正}}\) 发生的情况下,事件 \(A_{\text{白}}\) 发生的概率,就是条件概率 \(P(A_{\text{白}}|B_{\text{正}})=6/10=0.6\)。

已知事件 \(B_{\text{反}}\) 发生的情况下,事件 \(A_{\text{红}}\) 发生的概率,就是条件概率 \(P(A_{\text{红}}|B_{\text{反}})=8/10=0.8\)。

已知事件 \(B_{\text{反}}\) 发生的情况下,事件 \(A_{\text{白}}\) 发生的概率,就是条件概率 \(P(A_{\text{白}}|B_{\text{反}})=2/10=0.2\)。

从这个结果的推导可以看出,对于等概率模型的情况,下面关于条件概率的定义是合适的,即

将这个结果推广,我们得到下面的条件概率的定义:

其中假定 \(P(B)>0\) 。如果 \(P(B)=0\) ,相应的条件概率是没有意义的。 总而言之,\(P(A|B)\) 是事件 \(A \cap B\) 的概率与事件 \(B\) 的概率的比值。

这个式子可以理解成,在事件 \(B\) 发生的结果中,事件 \(A\) 发生的结果数和事件 \(B\) 发生次数的比值。 如下图所示,整个矩形空间 \(S\) 是全部结果集, 两个圆圈分别是事件 \(A\) 和是事件 \(B\) 发生的结果集, \(A\) 与 \(B\) 的交集部分,就是 \(A\) 与 \(B\) 同时发生的结果集。

图 1.2.1 \(P(A) = \frac{A}{S},P(B) = \frac{B}{S},P(A|B) = \frac{A \cap B}{B}= \frac{P(A \cap B)}{P(B)}\)¶

条件概率 \(P(A|B)\) 表示在 \(B\) 发生的条件下 \(A\) 发生的概率, 就是 限定在 \(B\) 的范围内 \(A\) 发生的概率。 \(B\) 的范围内就是 \(B\) 发生结果内, \(B\) 的范围内 \(A\) 的结果数是 \(A \cap B\) 结果数, 因此条件概率 \(P(A|B)\) 就等于

注意,这里分母是 \(B\) 而不是 \(S\) ,因为是 \(B\) 的前提下。 分子分母同时除以 \(S\) 后等价于

总结起来就一句话,条件概率就是把试验结果空间缩小到一个更小的空间,其它照旧。

1.3. 联合概率¶

假设两个随机事件 \(A\) 和 \(B\), 在已知 \(B\) 发生的条件下 \(A\) 发生的概率是条件概率 \(P(A|B)\) 。那如果不知道 \(B\) 是否发生了呢? 在没有任何已知条件下, \(A\) 和 \(B\) 同时发生的概率是什么呢?

我们定义,属于不同样本空间的多个随机事件同时发生的概率为联合概率 ,记作 \(P(A,B)\) 。

观察 图 1.2.1 ,\(A\) 和 \(B\) 同时发生的集合就是 \(A \cap B\) ,因此 \(A\) 和 \(B\) 的联合概率为

实际上,联合概率和条件概率之间是存在关系的,二者可以互相转换。

我们继续以箱子里取求为例,在上面的例子中,

事件 \(B_{\text{正}}\) 与 \(A_{\text{红}}\) 同时发生概率就是 \(P(B_{\text{正}},A_{\text{红}})=0.6\times 0.4=0.24\) 。

事件 \(B_{\text{正}}\) 与 \(A_{\text{白}}\) 同时发生概率就是 \(P(B_{\text{正}},A_{\text{红}})=0.6\times 0.6=0.36\) 。

事件 \(B_{\text{反}}\) 与 \(A_{\text{红}}\) 同时发生概率就是 \(P(B_{\text{正}},A_{\text{红}})=0.4\times 0.8=0.32\) 。

事件 \(B_{\text{反}}\) 与 \(A_{\text{白}}\) 同时发生概率就是 \(P(B_{\text{正}},A_{\text{红}})=0.4\times 0.2=0.08\) 。

也可以用一个 \(2\times 2\) 的表格来表示。

当随机事件更多的时候,上面的表格就无法表示了,此时可以用如下的表格

可以看到联合概率可以分解成条件概率的乘积,我们可以扩展到更多事件的联合概率。 假设有 \(A,B,C,D\) 四个随机事件,它们组成的联合概率可以分解为

更一般地,假设有 \(A_1,A_2,\cdots,A_N\) 共 \(N\) 个随机事件, 它们的联合概率可以写为

公式(1.3.6) 被称为联合概率的 链式法则 。

联合概率就是多个随机事件同时发生的概率,它的计算方法就是按照事件发生的先后顺序拆解成一系列条件概率的乘积。 在 公式(1.3.6) 中,事件 \(A_1\) 是第一个发生的事件,它的前面没有其它事件了, 因此 \(A_1\) 的发生概率不是条件概率,而是 \(P(A_1)\) 。 在 \(A_1\) 之后发生的事件就都是以 \(A_1\) 为前置条件了,依次类推,最后一个事件 \(A_N\) 是在其它 \(N-1\) 个事件之后发生的。

提示

先发生的事件是后发生的事件的前置条件,你可以把先发生的事件理解成”因”,后发生的事件看作是”果”, 那么条件概率就是一种因果关系。

最后,联合概率也是一个合格的概率律,也符合概率三公理。

1.4. 全概率与贝叶斯定理¶

上一节我们讲到,联合概率可以按照事件发生的顺序拆解成条件概率的乘积。 如果不按照事件发生的顺序呢,可不可以把顺序反过来呢? 答案是可以的,但是反过来后将会面临一个问题, 最后一个事件 \(A_N\) 的概率 \(P(A_N)\) 是什么?

我们继续以箱子取球为例, 为简化说明,我们重新定义事件 \(B\) 是事件 \(\{ B_{\text{正}},B_{\text{反}} \}\) 的集合, 记作 \(B=\{B_{\text{正}},B_{\text{反}}\}\) 。 同理,事件 \(A\) 是事件 \(\{A_{\text{红}},A_{\text{白}}\}\) 的集合, 记作 \(A=\{A_{\text{红}},A_{\text{白}}\}\) 。

在这个例子中,先投掷硬币,然后根据硬币的朝向决定从哪个箱子里取球。 因此事件 \(B\) 先发生,事件 \(A\) 后发生, 可以把事件 \(B\) 看做”因”,把事件 \(A\) 看做”果”。 根据链式法则,二者的联合概率 \(P(A,B)\) 可以写成

如果我们把 公式(1.4.2) 中的事件顺序反过来,就是

这时就产生了一个问题,\(P(A)\) 是多少? \(P(B|A)\) 又是多少? 形象一点就是, \(P(A)\) 代表 \(P(\text{果})\) , \(P(B|A)\) 代表 \(P(因|果)\) ,从”果”到”因”就是 推断(inference)问题 。 本节我们讨论的 全概率公式 和 贝叶斯定理 就是分别来求得 \(P(A)\) 和 \(P(B|A)\) 的方法, 我们先从 \(P(A)\) 说起。

事件 \(A=\{A_{\text{红}},A_{\text{白}}\}\) 表示球的颜色事件(集合),球的颜色有红白两种, 取到红球白球的概率会受到硬币事件 \(B=\{B_{\text{正}},B_{\text{反}}\}\) 的影响, 因此可以把事件 \(B\) 看做是”因” ,事件 \(A\) 看作是”果”。 现在我们回顾一下 \(B\) 与 \(A\) 的联合概率表,如下表所示。

事件 \(A=A_{红}\) 的状态被分割成了两部分,一部分是 \(P(A=\text{红},B=\text{正})\) ,另一部分是 \(P(A=\text{红},B=\text{反})\) 。显然 \(P(A=\text{红})\) 的概率需要把两部分加起来。

同理,\(P(A=\text{白})\) 为

可以看出,事件 \(A\) 的每个状态都被事件 \(B\) 分割了,分割的份数就是事件 \(B\) 的状态数量, 要想求得事件 \(A\) 每个状态的概率,就需要把被 \(B\) 分割的各个部分加起来才行。 总结起来就是这样

以上就是全概率公式,简单来说 全概率公式就是联合概率中消除掉一个事件得到剩余事件的概率。 消除掉的方法就是对这个事件的各个状态进行求和,如果被消除事件是一个连续值概率模型,就把求和符号换成积分。

回到最初的问题,我们已经可以通过全概率公式得到”果”的概率 \(P(A)\) , 现在看下如何从”果”推断出”因”,即 \(P(B|A)\) 。我们可以把 公式(1.4.2) 和 公式(1.4.3) 放在一起。

通过移项可得

其中分子部分 \(P(B)P(A|B)\) 是正向的”因果”关系,我们是已知的, 分母 \(P(A)\) 可以通过全概率公式得到。 二者的比值就得到了 \(P(B|A)\) 。

公式(1.4.10) 就是 贝叶斯定理, 又叫做贝叶斯公式。 贝叶斯定理就是贝叶斯推断的核心,经常被用来做 因果推断。 有许多”原因”可以造成某一种”结果”,当已知结果要推断成因时, 就是”因果推断”。所谓推断成因,就是推断出造成这一结果的每种原因的概率是多少。

现在设事件 \(B_1,B_2,\cdots,B_n\) 是原因,而 \(A\) 代表由原因引起的结果。 \(P(A|B_i)\) 表示在因果模型中由”原因” \(B_i\) 造成结果 \(A\) 出现的概率。 当观察到结果 \(A\) 的时候,我们希望反推结果 \(A\) 是由原因 \(B_i\) 造成的概率 \(P(B_i|A)\) 。 \(P(B_i|A)\) 代表新进得到的信息 \(A\) 之后 \(B_i\) 出现的概率, 因此称之为 后验概率。 \(P(B_i)\) 是在没有信息之前就知道的 \(B_i\) 出现的概率, 因此称之为 先验概率。 \(P(A|B_i)\) 是有了原因 \(B_i\) 之后 \(A\) 出现的可能性 ,因此称之为 似然。 最后,贝叶斯公式可以用如下方式描述。

此外,可以注意到,分母全概率公式 \(P(A)=\sum_B P(B)P(A|B)\) 其实就是分子 \(P(B)P(A|B)\) 的累加。

因此作为分母的全概率可以看做是分子的 归一化项, 归一化的结果是把等式右侧的数值转换到区间 \([0,1]\), 使其符合概率的定义。相对于分子来说,分母的值是固定不变的, 贝叶斯公式 公式(1.4.12) 可以简写成一个正比关系。

1.5. 独立性¶

前面的内容中,我们探讨了多个随机事件的关系,条件概率、联合概率以及因果推断 。那如果两个随机事件没有任何关系呢? 如果随机事件之间没有任何关系,我们称它们是 相互独立事件。

如果两个事件 \(A\) 和 \(B\) 是相互独立的,则事件 \(B\) 的发生不会改变事件 \(A\) 的概率,反之亦然。

在上述等式成立的情况下,我们称事件 \(A\) 独立于事件 \(B\), 记作 \(A \perp \!\!\! \perp B\) 。 如果两个事件是独立的,则它们的联合概率将变得简单。

有些时候,单独看两个事件可能不是独立的,但是在给定另外一个条件下是独立的。 例如在给定事件 \(C\) 发生的情况下,事件 \(A\) 与 \(B\) 是相互独立的,记作 \(A \perp \!\!\! \perp B | C\) ,这种情况称之为 条件独立 。

1.6. 随机变量¶

试验的所有可能结果形成了样本空间 \(\Omega=\{\omega_1,\omega_2,\cdots,\omega_n\}\) , 样本空间中的每个样本点 \(\omega_i\) 就表示试验的一种可能结果, 一个试验的结果必定是样本空间 \(\Omega\) 中的一个。 在许多概率模型中试验结果是数值化的,例如股价或者骰子的点数等等, 也有一些试验结果不是数值化的,例如投硬币的结果。 显然这样既有非数字又有数值的情况,不利于我们的研究和处理, 因此我们希望能全部转换成数值进行处理, 而这可以通过 随机变量 来实现。

我们把样本空间中的每一个可能的试验结果,关联一个特定的数, 这种试验结果与数的对应关系形成 随机变量 。 更直白的说就是,我们用一个变量符号来表示实验结果, 变量的取值就是试验结果所对应的数。 从数学上将,随机变量是试验结果的实值函数, 随机变量通常用大写的字母表示。 我们用两个例子来说明。

首先以投硬币的试验为例,投硬币的结果形成样本空间 \(\Omega=\{\text{正},\text{反}\}\) ,首先我们需要把非数值的样本映射成数值,比如我们把正面向上的结果映射成数字 \(1\), 把反面向上的结果映射成数字 \(0\) ,样本空间就变成了一个数值空间 \(\Omega=\{1,0\}\) 。然后定义一个随机变量 \(X\) 来表示试验的结果,那么变量 \(X\) 的取值空间就是数值空间 \(\Omega=\{1,0\}\) 。 \(X=1\) 表示试验结果是正面向上, \(X=0\) 表示试验结果是反面向上。

再比如掷骰子的试验中,试验结果的样本空间就是六种点数, 记作 \(\Omega=\{1,2,3,4,5,6\}\) 。在这个试验中,样本空间已经是数值化了,因此就不需要进行数值转化了, 我用变量 \(X\) 表示试验的结果,则变量 \(X\) 的的取值空间就是 \(\{1,2,3,4,5,6\}\) ,通常用小写的字母表示变量的取值,此时变量 \(X=x\) 就表示试验结果是 \(x\) 。

现在再举几个随机变量的例子。

连续抛掷一枚硬币共 \(5\) 次,在这个试验中正面出现的次数是一个随机变量。

- 在两次抛掷一个骰子的试验中,下面的例子是随机变量。

两次抛掷骰子所得到的的点数之和。

两次抛掷得到 \(6\) 点的次数。

第二次抛掷所得到的点数的 \(5\) 次方。

在传输信号的试验中,传输信号所需的时间、接收到的信号中发生错误的次数、传输信号过程中的时间延迟等都是随机变量。

随机变量的这些特性当中,比较重要的一点是,随机变量的函数仍然是一个随机变量 。 这一点在本书之后的内容中会使用,比如统计量、参数估计量就是建立在这一点之上。

提示

如果你难以理解随机变量的概念,没关系,可以暂时先把随机变量就理解成随机事件。虽然这样不是很准确, 但不妨碍对本书之后内容的理解。随机事件拥有的特性随机变量也有,比如条件概率、联合概率、独立性等等, 二者的差别就是,随机事件只有发生、不发生两种结果,而随机变量可以多种结果值,并且随机变量的值是数值(数字)。

样本空间的大小可以是有限的,也可以是无限的,有限的样本空间是离散概率模型, 无限的样本空间是连续值概率模型。 随机变量是样本空间的实值函数, 因此随机变量也分为 离散随机变量 和 连续随机变量 。

1.6.1. 离散随机变量¶

若一个随机变量的值域(随机变量的取值范围)为一个有限集合或最多为可数无限集合, 则称这个随机变量为 离散的 。 由于它只能取有限多个值,所以是离散的随机变量。

离散随机变量,既然称为 随机 变量,意味着它的取值并不是确定性, 而是具有 随机 性,有可能是值域中的任何一个值, 值域中每个值都有一定的概率。 假设随机变量 \(X\) 表示一次投掷硬币的试验结果, \(X=1\) 表示正面向上结果,\(X=0\) 表示反面向上的结果, 对于一枚正常的硬币两种结果应该是等概率的, 随机变量 \(X\) 每种取值的概率情况为

对于离散随机变量,其值域是有限个,因此有时也可以用一个表格的形式表达其各个值的概率情况

我们把一个随机变量各个可能取值的概率分布情况,称为随机变量的 概率分布。 虽然我们可以用表格的形式表达离散随机变量的概率分布,但是如果随机变量的值域规模较大, 表格将变得异常庞大,使用起来也是不方便的。 此时,可以用一个 数学函数 来表达随机变量的概率分布, 用来表达随机变量的概率分布的函数就称为 概率分布函数 。 比如,对于仅有 \(\{0,1\}\) 两个值的随机变量 \(X\) ,假设其为 \(1\) 的概率是 \(\pi\) ,那么它的概率分布函数可以为

把随机变量的某个可能取值代入到概率分布函数,得到的就是变量为这个值的概率。 我们把 \(1\) 代入到 公式(1.6.3) 得到就是随机变量 \(X\) 为 \(1\) 的概率 \(P(X=1)\) 。

同理,把 \(0\) 带入到 公式(1.6.3) 得到就是 \(P(X=0)\) 。

前文已经讲过随机变量是随机事件的一个扩展,随机变量的概率分布也是满足概率三公理的, 包括非负性、可加性和归一化。 假设有一个离散随机变量 \(Y\), 其值域空间为 \(\{y_1,y_2,\cdots,y_n\}\) ,任意一个值 \(y_i\) 的概率记为 \(P(y_i)\) ,则有如下归一化等式成立。

1.6.2. 连续随机变量¶

在前文讲过,当样本空间有无限个样本点时就是连续概率模型, 同理,若一个随机变量可以取到无限多个数, 那么这个随机变量就是 连续值随机变量 。 在连续概率模型中,单个样本点的概率是 \(0\) , 我们需要把整个连续的样本区间划分成子区间,让后定义样本点落在每个子区间的概率。 同理,连续值随机变量也是一样的。

假设一个连续值随机变量 \(X\) ,其值域空间是整个实数域 \(X \in \mathcal{R}\) ,它的概率分布函数是 \(f(x)\) 。 随机变量 \(X\) 的取值落在区间 \([a,b]\) 的概率为

一定要注意,对于连续值随机变量的概率分布函数 \(f(x)\) ,\(f(x)\) 的值并不是概率值,而是这一点的 密度值 , 在一个区间上的积分结果表示随机变量落在这个区间的概率值。

如果我们把这个区间 \([a,b]\) 扩大到 \(X\) 的整个值域空间 \(\mathcal{R}\) ,此时相当于 \(a=-\infty,b=\infty\), 不管试验结果是什么,\(X\) 的值肯定会落在自己的值域空间, 落在整个值域空间的概率必然是 \(1\) 。 因此有如下约束必须满足

也就是说,我们约束连续值随机变量概率分布函数在整个值域的积分必须是 \(1\) ,这就和离散随机变量值域内所有值的概率之和是 \(1\) 一样。 虽然在这个例子中,连续值随机变量 \(X\) 的值域是整个实数域,但这不是必须的, 连续值随机变量的值域空间可以是任意的区间,一般是根据试验的样本空间确定的, 对值域空间的范围和大小并没有额外的限制。 但不管值域空间是如何的,都是可以通过调整 \(f(x)\) 以使得它在整个空间的积分是 \(1\) 。

离散随机变量的概率分布函数可以直接为每个点计算出概率值(类比于每个点的质量), 因此通常称为 概率质量函数(probability mass function, pmf), 而连续值随机变量的概率分布函数,需要积分才能得到概率值(质量), 函数本身相当于每个点的 密度值 , 因此连续值随机变量的概率分布函数一般称为 概率密度函数(probability density function, pdf) 。

1.6.3. 累积分布函数¶

对于离散随机变量和连续随机变量分别用概率质量函数和概率密度函数刻画他们的概率分布情况, 本节我们介绍另一种刻画概率分布的方法,累积分布函数(Cumulative Distribution Function,CDF) 。

累积分布函数是概率质量(密度)函数的积分函数, 通常使用小写字母 \(f\) 代表概率质量(密度)函数和函数,而用大写字母 \(F\) 表示累积分布函数。

在一个概率模型中,随机变量可以有不同的类型,可以是离散的,也可以是连续的,甚至可以是既非离散也非连续的。 但不管什么类型的随机变量,它们都会有一个相对应的累积分布函数。 这是因为 \(\{X \le x\}\) 是一个随机事件,这些事件的概率形成概率分布。

1.6.4. 随机变量的函数¶

之前已经提到过,你可以把随机变量看做随机事件的扩展,随机事件只有发生、不发生两个状态, 而随机变量是试验结果样本空间到数值的映射,它可以有更多的状态,样本空间中每个样本点对应着随机变量的一个取值。 随机事件拥有的特性随机变量也有, 比如条件概率、联合概率、贝叶斯定理等等, 对随机变量都是成立的,只需要把那些大写字母的符号看做是随机变量即可, 这里就不再赘述了。 本节我们讨论之前没有讨论过的内容, 随机变量的函数。

假设 \(X\) 是一个随机变量, \(g(X)\) 是随机变量 \(X\) 的一个函数, \(g(X)\) 就相当于对 \(X\) 施行了一个变换, 这种变换可以是线性的也可以是非线性的。 假设 \(g(X)\) 是一个线性变换

其中 \(a,b\) 是数值。 我们也可以考虑非线性的函数,比如

设 \(Y=g(X)\) 是随机变量 \(X\) 的函数, 由于对于 \(X\) 的每一个可能取值,也对应的 \(Y\) 的一个数值,故 \(Y\) 也是一个随机变量, \(Y\) 的概率分布可以通过 \(X\) 的概率分布计算得到。

设离散随机变量 \(X\) 的值域为 \(\{-1,-2,0,1,2\}\) ,并且每个值的概率都是 \(1/5\) 。 \(Y\) 是 \(X\) 的平方,即 \(Y=g(X)=X^2\) ,则 \(Y\) 的取值空间为 \(\{0,1,4\}\) 。

\(Y\) 的概率分布为

多个随机变量的函数也是一样的。假设 \(X\) 和 \(Y\) 是两个随机变量, 那么 \(Z=g(X,Y)\) 也是一个随机变量,即使更多的随机变量的函数也是如此。

1.6.5. 期望与方差¶

随机变量的取值不是确定性的,有一定的随机性,它的概率分布给出了其所有可能取值的概率。 随机变量的概率分布不是很方便进行比较和评价, 通常,我们希望将这些信息综合成一个能代表这个随机变量的 数值 。 在数学和统计学中,矩(moment) 是对变量分布和形态特点的一组度量。 n阶矩 被定义为变量的 \(n\) 次方与其概率分布函数之积的积分, 变量的 一阶矩 就是变量的期望值,也叫平均值。

随机变量的期望值是一个数值,而不再是随机变量。 随机变量的期望值可以看做是这个变量的 中心 , 大量重复试验结果的数学平均值就渐近等于变量的期望值, 在之后讲最大似然估计时会详细介绍。

我们已经知道随机变量的函数也是一个随机变量,随机变量的函数的期望可以用如下方式得到。

直接使用变量计算的矩被称为原始矩(raw moment),比如期望就是原始矩。 移除均值后计算的矩被称为中心矩(central moment), 变量的一阶原始矩等价于数学期望(expectation)、二至四阶中心矩被定义为方差(variance)、偏度(skewness)和峰度(kurtosis) 。

随机变量另一个常见的独立方法就是 方差(variance) ,方差是二阶中心矩 。所谓中心矩就是去除中心(期望值), 所谓的二阶就是二次方,因此方差的计算方法为

注意上式中最外层又求了一次期望,这是因为 \((X-\mathbb{E}[X])^2\) 本身是随机变量 \(X\) 的一个函数, 它也是一个随机变量,因此再对它求一次期望以便得到一个 数值 。 根据随机变量函数期望的求法,方差的计算方法为

其中 \(f(x)\) 是变量 \(X\) 的概率分布函数。

方差的值是原始变量的平方,量纲发生了变化,其量纲是原始值的平方,不利于和原始值进行比较, 因此定义方差的非负平方根为 标准差 , 标准差和原始变量的量纲是一致的,可以直接进行比较。

现在我们来看一下均值和方差的一些性质, 首先考虑随机变量 \(X\) 的线性函数

其中 \(a\) 和 \(b\) 是已知常数, \(f(x)\) 为随机变量 \(X\) 的概率分布函数, 关于线性函数 \(Y\) 的均值和方差,我们有

进一步地

此外,还有一个用矩表达方差的重要公式。

1.7. 边缘化¶

假设已知随机变量 \(A\) 和 \(B\) 的联合概率分布为 \(P(A,B)\), 以及变量 \(A\) 的概率分布 \(P(A)\),现在想求出变量 \(B\) 的概率分布 \(P(B)\)。 这个过程就是把 \(B\) 进行边缘化,求出边缘概率分布 \(P(B)\) 。

它的计算过程其实就是利用全概率公式把变量 \(A\) 从联合概率分布中 消除掉, 因此可以称为 消元法。

当已知 \(P(A)\) 和 \(P(A,B)\),可以利用边缘化的方法求得 \(P(B)\) 的概率分布。 即使更多的随机变量也是如此, 比如,已知 \(4\) 个变量的联合概率分布 \(P(A,B,C,D)\) 以及 \(P(C),P(D|C)\), 想要求 \(P(A,B)\) 的概率分布,这时就需要”边缘化”随机变量 \(A\) 和 \(B\), 也就是从 \(P(A,B,C,D)\) “消除掉”随机变量 \(C\) 和 \(D\), 从而得到 \(P(A,B)\) 。

如果是连续随机变量,就把求和换成积分。

1.8. 常见概率分布¶

本节我们介绍一些已知的并且常用的概率分布, 这些概率分布会在本书之后的章节中频繁使用, 需要读者对这些分布的特性十分熟悉。

1.8.1. 伯努利分布¶

伯努利分布是最简单的离散概率分布,伯努利分布是单次伯努利试验结果的分布。 伯努利试验(Bernoulli experiment) 是在同样的条件下重复地、相互独立地进行的一种随机试验, 其特点是该随机试验只有两种可能结果:发生或者不发生。 最简单的例子就是投掷硬币的试验,投掷硬币的结果只有正面(正面发生)和反面(正面不发生)两种结果, 投硬币试验就是一种伯努利实验。

单次伯努利试验结果的概率分布就称为伯努利概率分布,服从伯努利概率分布的随机变量可以称为 伯努利变量 。假设随机变量 \(X\) 是伯努利变量,设正面向上的概率为 \(\pi\), 则反面向上的概率为 \(1-\pi\) ,正面向上的结果用数字 \(1\) 表示, 反面向上的结果用数字 \(0\) 表示,即

它的概率分布为

分段函数不利于参与计算,通常伯努利变量的概率质量函数可以写成如下简单的形式

根据随机变量期望的计算公式,伯努利变量的期望为

可以看到,对于伯努利变量来说, \(\pi\) 既是 \(X=1\) 的概率,也是它的期望值。 我们再来看下伯努利变量的方差。

1.8.2. 二项式分布¶

单次伯努利试验的结果分布是伯努利分布,如果进行多次伯努利试验,试验结果中证明向上的次数定义为随机变量 则这个随机变量的概率分布是二项式分布, 注意这多次伯努利试验要求是同样的条件下重复地、相互独立地进行的。

假设我们在同样的条件下重复地、相互独立进行了 \(n\) 次伯努利实验, 单次试验成功的概率为 \(\pi\), \(n\) 试验后一共成功的次数为 \(X\) ,则 \(X\) 的概率分布称为二项式分布,一般记作 \(X \sim B(n,\pi)\), 其概率质量函数为

变量 \(X\) 表示在 \(n\) 次试验中成功的次数,只是一个次数累计, 对成功的位置并没有限制,因此在 \(n\) 次试验中任意位置成功 \(X\) 次都可以, 所以上式中需要一个组合数项 \(\binom{n}{x}\) 。 由于是在同样的条件下重复地、相互独立的进行试验, 因此每一次试验成功的概率都是 \(\pi\) 。

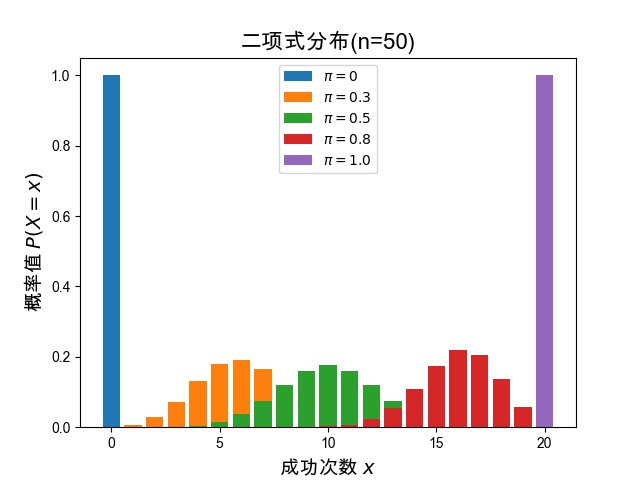

二项式变量 \(X\) 表示 \(n\) 次伯努利试验中成功的次数 ,它的期望值 \(n \pi\)。 现在我们把它的概率分布用柱状图的形式呈现出来,以便直观的感受其中的变化。

图 1.8.1 当 \(\pi=0\) 时,\(P(X=0)=1,P(X>0)=0\) ; 当 \(\pi=1\) 时,\(P(X=n)=1,P(X<n)=0\) 。¶

图 1.8.1 所示是进行 \(n=50\) 次伯努利试验时, 不同 \(\pi\) 值的情况下,二项式变量 \(X\) 的概率分布图。 可以看到概率最大(最高的柱子)的点就是期望值 \(n \pi\) 的点 ,随着从期望值的点向着两侧延伸概率逐渐变小。 有两个特殊的情况,当 \(\pi=0\) 时意味着成功的概率是 \(0\) ,因此图形上 \(x=0\) 的点概率是 \(1\),其它点 \(x>0\) 的概率是 \(0\) 。反过来,当 \(\pi=1\) 时意味着成功的概率是 \(1\), 因此图形上 \(x=n\) 的点的概率是 \(1\),其它点 \(x<n\) 的概率是 \(0\)。

最后我们看下二项式分布的方差,其计算过程如 公式(1.8.8) 所示, 可以看到二项式分布的方差就是伯努利分布方差的 \(n\) 倍。

1.8.3. 类别分布¶

伯努利随机变量只有两个离散状态, 如果一个离散随机变量拥有更多的离散状态,就称这个变量为类别变量(categorical variable) ,它的概率分布称为类别分布(categorical distribution)。 显然类别随机变量也是一个离散随机变量,它比伯努利变量拥有更多的可能取值。

假设随机变量 \(X\) 是一个拥有 \(K\) 个可能取值的离散随机变量 其取值空间记作 \(\mathcal{X}=\{x_1,\dots,x_K\}\)。 变量 \(X\) 取值为 \(x_i\) 的概率记作 \(\pi_i\) ,类似于伯努利变量,类别变量的概率质量函数可以用一个分段函数表示。

同样也需要满足概率和为 \(1\) 的约束, \(\sum_{k=1}^K \pi_k = 1\)。

分段函数的形式不够简洁,通常会借用一个指示函数改写一下类别分布的概率质量函数, 使它的形式更利于参与到各类复杂计算中。

利用指示函数可以把 公式(1.8.9) 改写成如下更简洁的形式。

虽然通常会用连续的整数 \({1,2,3,\cdots,K}\) 表示对应的类别 \(\{x_1,x_2,x_3,\cdots,x_K\}\) ,但是要注意,对于类别变量的各个类别 \(x_k\) 之间是没有任何顺序、大小关系的,各个类别之间是独立的。 因此它的期望和方差也是每个类别单独计算。

由于类别变量类别数多于 \(2\) 个,所以还需要给出类别之间的协方差。

1.8.4. 多项式分布¶

我们知道,二值离散变量称为伯努利变量(Bernoulli variable),其概率分布称为伯努利分布(Bernoulli distribution), 多次伯努利采样称为二项式分布(binomial distribution),伯努利分布是二项式分布特例,即仅进行单次试验的情况。 相对应的,多值离散变量称为类别变量(categorical variable),其概率分布称为类别分布(categorical distribution), 多次类别分布采样称为多项式分布(multinomial distribution),类别分布是多项式分布的特例。

我们用M表示变量的取值个数,比如对于伯努利变量 \(K=2\) ,用 \(n\) 表示试验次数(采样次数):

当 \(K=2,n=1\) 时,是伯努利分布(Bernoulli distribution)。

当 \(K=2,n>1\) 时,是二项式分布(binomial distribution)。

当 \(K>2,n=1\) 时,是类别分布(categorical distribution)。

当 \(K>2,n>1\) 时,是多项式分布(multinomial distribution)。

假设随机变量 \(X\) 服从多项式分布,\(x_k\) 表示 \(n\) 次试验结果中类别 \(k\) 出现的次数。对照着二项式分布的概率质量函数,可以直接给出多项式分布的概率质量函数。

同理多项式分布的期望和方差也是每个类别单独计算的。

1.8.5. 高斯分布¶

高斯分布(Gaussian distribution),以德国数学家卡尔·弗里德里希·高斯的姓冠名, 因其是日常生活中最常见的连续值概率分布, 常在自然和社会科学领域中代表一个不明的随机变量,在统计学上十分重要, 经常又被称为正态分布(Normal distribution)、常态分布、正规分布。

一个连续随机变量 \(X\) 若它的概率密度函数具有如下形式,则称它为高斯随机变量或者正态随机变量, 记作 \(X \sim N(\mu,\sigma^2)\) 。

高斯随机变量的期望和方差由下式给出

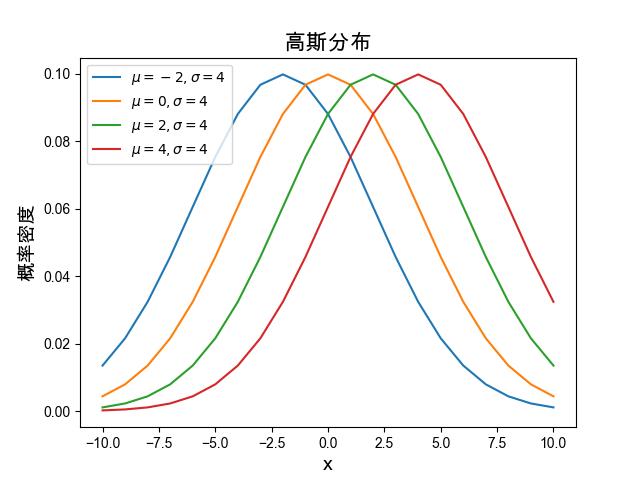

高斯变量的概率密度函数 公式(1.8.16) 中的 \(\mu\) 和 \(\sigma^2\) 分别对应着变量的期望和方差,\(\sigma\) 为标准差(standard deviation, SD)。 期望决定分布的”中心”,方差影响着分布的”宽度”, 我们通过图形来直观的感受下。

图 1.8.2 固定标准差参数 \(\sigma=4\),不同的期望参数 \(\mu\) 下图形的变化。¶

图 1.8.2 是期望参数不同取值的情况下,高斯分布概率密度函数图形的变化, 为了凸显期望参数的影响, 我们固定方差参数的值。 高斯分布的概率密度函数的曲线呈现一个重型曲线的形状,曲线的最高点就是期望值所在的点,显然期望值是概率最大的点。 随着期望值从 \(-2\) 到 \(4\) 的变化,钟形曲线向右发生平移, 因为曲线的中心在右移, 期望值的变化会导致概率密度函数的曲线发生平移。

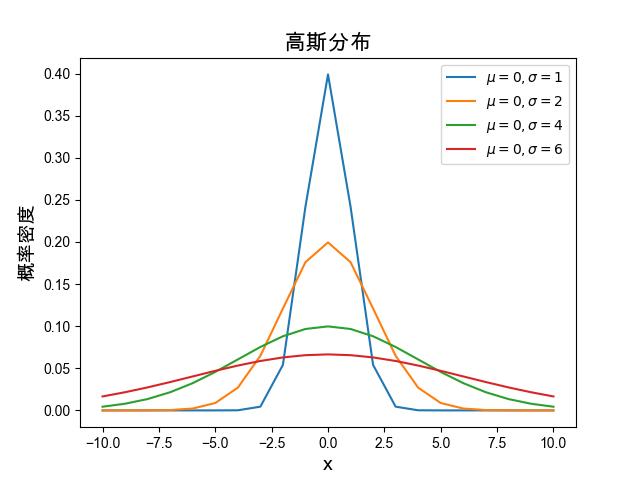

图 1.8.3 固定期望参数 \(\mu=0\),不同的标准差参数 \(\sigma\) 下图形的变化。¶

接下来,我们固定期望值参数为 \(0\), 观看不同的方差参数对曲线的影响,如 图 1.8.3 所示。 可以看出方差 \(\sigma^2\) 越小图形越”尖锐” ,反之,方差 \(\sigma^2\) 越大图形越”宽胖”。

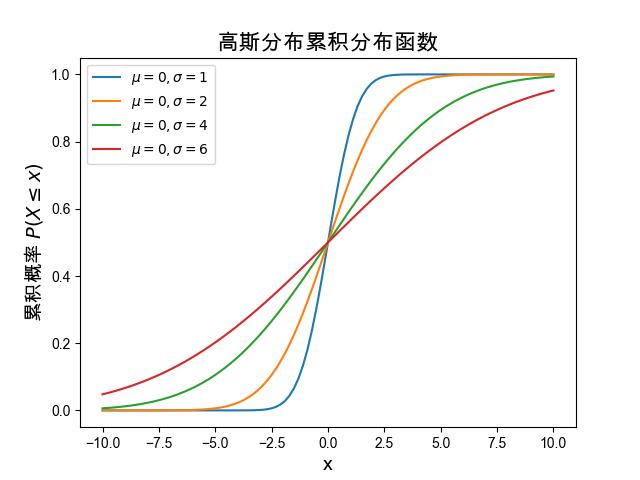

正态分布的累积分布函数(CDF)为

图 1.8.4 是正态分布的累积分布函数的图形, 由于均值参数 \(\mu\) 只影响图形的左右平移,不影响图形的形状, 因此我们固定了均值参数 \(\mu=0\) ,观看不同标准差参数 \(\sigma\) 对图形曲线的影响。 可以看到标准差 \(\sigma\) 影响着曲线的斜率, \(\sigma\) 越小曲线斜率越大,斜率越大说明累积概率上升的越快, 对照着 图 1.8.3 的概率密度曲线,不难理解这一点。

图 1.8.4 固定均值 \(\mu=0\) 时,不同标准差 \(\sigma\) 下正态累计分布函数的变化。¶

标准正态分布

满足 \(\mu=0,\ \sigma^1=1\) 的正态分布称为 标准正态分布, 此时其概率密度函数变得简单

标准正态分布的累积分布函数习惯上记作 \(\Phi\) 。

任意一个非标准的正态随机变量都可以转换成标准正态随机变量。 假设一个随机变量 \(X \sim N(\mu,\sigma^2)\) ,则有如下随机变量是标准正态随机变量。

这个转换关系一定要牢记预选,在本书之后的内容中会多次应用。

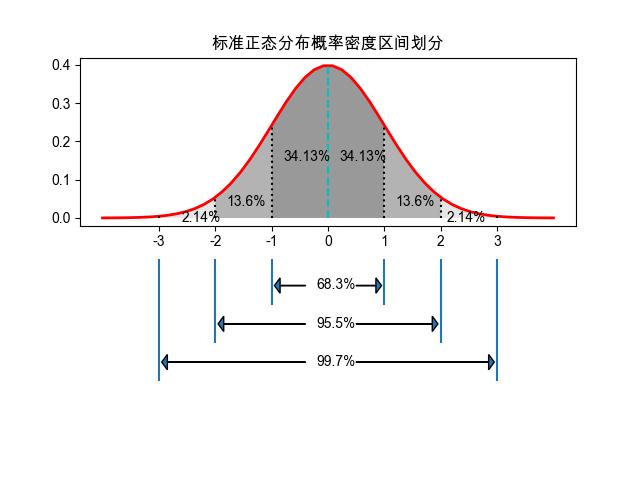

我们知道正态分布的概率密度函数曲线是一个左右对称的钟形曲线, 对称的中心线就是期望值 \(\mu\) 的直线, 期望值附近的概率是最大的。 根据连续值随机变量概率密度的定义,概率密度函数曲线和 \(x\) 轴所围成的整个区域面积为 \(1\) ,我们可以把整个区域成一些固定的子区域。 如 图 1.8.5 所示, 以 \(0\) 点为中心,向两边延伸, \([0,1]\) 的区间面积占整个曲线面积的 \(34.13\%\) ,由于曲线是对称的,\([-1,0]\) 的区间面积也是 \(34.13\%\) 。同理, \([1,2]\) 和 \([-2,-1]\) 都是 \(13.6\%\) ,\([2,3]\) 和 \([-3,-2]\) 都是 \(2.14\%\) 。

图 1.8.5 标准正态分布 \(N(0,1)\) 概率密度函数的区间划分。¶

我们把中心两边合并起来,\([-1,1]\) 的区间面积占比就是 \(68.3\%\) , \([-2,2]\) 的区间面积占比就是 \(95.5\%\), \([-3,3]\) 的区间面积占比就是 \(99.7\%\), 剩下的两端 \((-\infty,-3)\) 以及 \((3,\infty)\) 加起来不足 \(0.3\%\)。 这意味,如果我们从一个服从标准正态分布 \(N(0,1)\) 的随机变量进行取样(试验),样本值(试验结果)落在

区间 \([-1,1]\) 的概率是 \(68.3\%\) 。

区间 \([-2,2]\) 的概率是 \(95.5\%\) 。

区间 \([-3,3]\) 的概率是 \(99.7\%\) 。

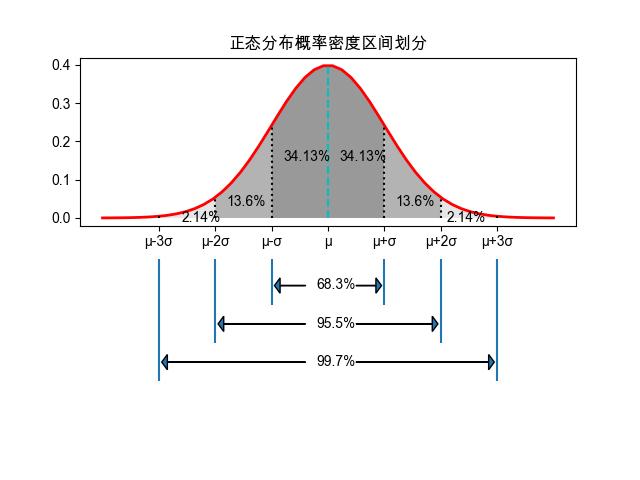

上面是对标准正态分布概率密度函数的区间划分,那非标准正态分布是什么样的呢? 其实是类似的,变化的只是子区间的范围而已。 图 1.8.6 是正态分布 \(N(\mu,\sigma^2)\) 的概率密度函数曲线的区间划分, 和标准正态分布相比只是横轴发生了平移和缩放而已, 中心的不再是 \(0\) 而是 \(\mu\), 子区间扩大了一个标准差 \(\sigma\) 。

图 1.8.6 正态分布 \(N(\mu,\sigma^2)\) 概率密度函数的区间划分。¶

区间 \([\mu-1\sigma,\mu+1\sigma]\) 的概率是 \(68.3\%\) 。

区间 \([\mu-2\sigma,\mu+2\sigma]\) 的概率是 \(95.5\%\) 。

区间 \([\mu-3\sigma,\mu+3\sigma]\) 的概率是 \(99.7\%\) 。

正态分布概率密度函数曲线的这个区间划分一定要理解, 在之后讨论假设检验时会使用到。

1.8.6. 卡方分布¶

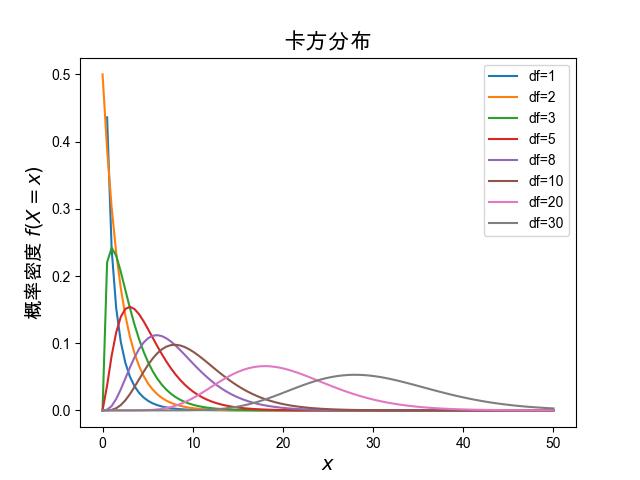

高斯变量的线性变换后仍然是服从高斯分布的,本节我们看下非线性的结果。 设随机变量 \(Z_i\) 是均值为 \(0\) 方差为 \(1\) 的标准正态分布变量, 随机变量 \(X\) 是由 \(k\) 个独立的 标准正态分布变量 的平方和组成。

则随机变量 \(X\) 被称为服从自由度(degree of freedom, df)为 \(k\) 的卡方分布,记作 \(X \sim \chi^2(k)\) 。 卡方分布(chi-square distribution), 也可以写作 \(\chi^2\) 分布, 是一种特殊的伽玛分布,是统计推断中应用最为广泛的概率分布之一,例如假设检验和置信区间的计算。 卡方分布的概率密度函数为:

卡方分布是一个平方和,因此变量值一定是大于等于0的,对于 \(x <0\),

我们认为 \(f(x)=0\) 。

公式中的符号 \(\Gamma\) 表示 Gamma 函数,

Gamma 函数相当于阶乘函数在实数域的扩展,

有关 Gamma 函数更多的细节我们以后再讨论。

卡方分布的概率密度函数看上去十分复杂,没关系,我们不需要记住,需要的时候翻书就可以了。

自由度为 \(k\) 的卡方变量的平均值是和方差是分别为

现在我们来看下不同自由度下,卡方分布概率密度函数曲线的变化, 如 图 1.8.7 所示, 可以看到随着自由度的增加,卡方分布的曲线逐步变成钟形曲线, 越来越进行正态分布。

图 1.8.7 随着自由度的增加,卡方分布的曲线逐步变成钟形曲线。¶

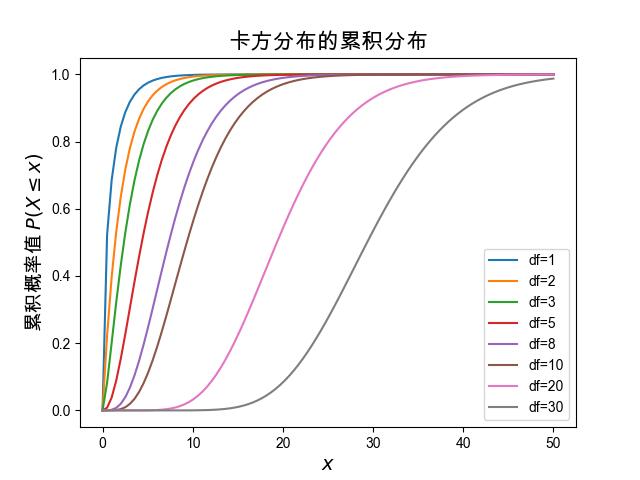

卡方分布的累积分布函数为

其中 \(\gamma\) 为不完全 \(\Gamma\) 函数。

图 1.8.8 卡方分布的累积分布函数。¶

可以明显看出卡方分布的自由度参数影响着其累积分布函数的斜率, 自由度越小斜率越大,自由度越大斜率越小。

卡方分布的可加性

由卡方变量的定义可得,独立卡方变量之和同样服从卡方分布。 特别地,若 \(X_{1},X_{2},\dots X_{n}\) 分别独立服从自由度为 \(k_{1},k_{2},\dots k_{n}\) 的卡方分布, 那么它们的和 \(\sum _{i=1}^{n} X_{i}\) 服从自由度为 \(\sum _{i=1}^{n}k_{i}\) 的卡方分布。

非中心化卡方分布

卡方分布的定义中要求是 标准正态分布(期望为0,方差为1) 的平方和,那如何不是标准正态分布呢?

设随机变量 \(Z_i\) 是均值为 \(\mu_i\) 方差为 \(1\) 的正态分布变量, 随机变量 \(X\) 是由 \(k\) 个独立的 单位方差正态分布变量 的平方和组成。

则随机变量 \(X\) 被称为服从自由度为 \(k\) 的 非中心化卡方分布(Noncentral chi-squared distribution), 为了区分二者,由标准正态分布得到的卡方分布可以称为 中心化卡方分布。 非中心化卡方分布的概率密度函数中多了一个非中心化参数 \(\lambda\) 。

其中 \(f_{Y_{k+2i}}(x)\) 是自由度为 \(k+2i\) 的中心卡方分布的概率密度函数。 \(\lambda\) 称为非中心化参数(non-centrality parameter), 由下式给出

非中心化卡方分布的概率密度函数变得异常复杂,我们无需关注它的细节, 只需要清楚非中心化卡方分布和中心化卡方分布的区别即可。 非中心化卡方分布的期望和方差为

1.8.7. t分布¶

t分布的推导最早由大地测量学家F riedrich Robert Helmert 于1876年提出,并由数学家 Lüroth 证明。

英国人威廉·戈塞(Willam S. Gosset)于1908年再次发现并发表了t分布,

当时他还在爱尔兰都柏林的吉尼斯(Guinness)啤酒酿酒厂工作。

酒厂虽然禁止员工发表一切与酿酒研究有关的成果,

但允许他在不提到酿酒的前提下,以笔名发表t分布的发现,所以论文使用了“学生”(Student)这一笔名。

之后t检定以及相关理论经由罗纳德·费希尔(Sir Ronald Aylmer Fisher)发扬光大,

为了感谢戈塞的功劳,费希尔将此分布命名为学生t分布(Student’s t)。

t分布是标准正态分布的一个近似分布,当不知道标准正态分布的方差时,

经常用t分布做标准正态分布的一个替代(近似)。

假设 \(X\) 是呈正态分布的独立的随机变量, 它的期望值为 \(\mu\), 方差为 \(\sigma^2\),方差未知。 令 \(X_1,X_2,\cdots,X_N\) 为随机变量 \(X\) 的一个独立同分布的观测样本序列, 则样本的均值为

样本的方差为

定义如下变量

则变量 \(T\) 是一个随机变量,它的分布称为 t-分布, 它的概率密度函数是

其中 \(\nu=N-1\),参数 \(\nu\) 一般称为自由度,\(\Gamma\) 是伽马函数。 当 \(\nu>1\) 时,它的期望是 \(0\),\(\nu=1\) 时未定义。 当 \(\nu>2\) 时,它的方差是 \(\nu/(\nu-2)\),否则无穷大。

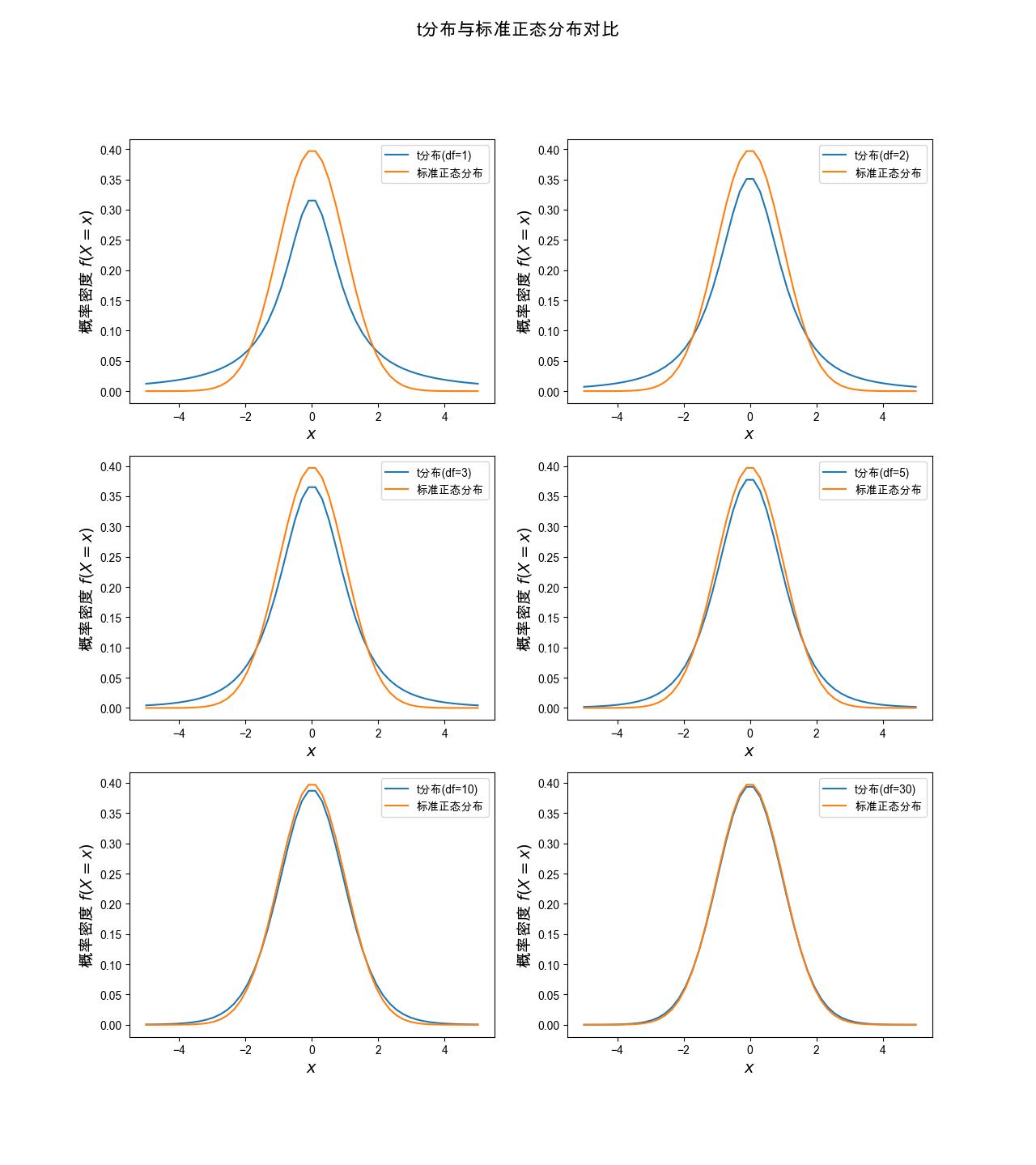

t分布作为标准正态分布的近似分布,它的概率密度函数曲线和标准正态分布是非常接近的, 并且随着自由度的增加,二者越来越接近,当自由度足够大时,t分布就等价于标准正态分布。 图 1.8.9 展示了自由度分别为 \(1, 2, 3, 5, 10, 30\) 时, t分布和标准正态分布的差异,可以看到当自由度是 \(30\) 时,二者已经基本重合。

图 1.8.9 t分布的概率密度函数和标准正态分布概率密度函数的对比。 当自由度为 \(30\) 时,二者基本重合。¶

从图形可以看出,二者期望是一样的,都是 \(0\) 。当自由度小于 \(30\) 时, t分布的方差是略大于标准正态分布的。 当我们不知道标准正态分布的方差时, 就可以通过标准正态分布的采样(观测)样本计算一个样本方差, 利用样本方差确定一个t分布, 然后用这个t分布近似模拟原来的标准正态分布进行后续的分析使用, 当然如果你的采样样本数量超过 \(30\) 个, 直接使用样本方差作为标准正态分布的方差估计值, 然后直接使用标准正态分布 \(N(0,S_N)\) 进行分析使用也是可以的, 因为此时t分布和标准正态分布已经没有区别了。

1.8.8. F分布¶

卡方分布、t分布和F分布是统计学中正态总体的三大抽样分布, 有关什么是总体分布与抽样分布,我们在 节 3.2 会详细讨论。

F分布也是一个连续值分布,它概率密度函数十分复杂,本书不需要过多关注,这里就不再给出概率密度函数函数的具体形式。 我们重点关注卡方分布和F分布的关系。

假设 \(U_1\) 和 \(U_1\) 分别自由度为 \(d_1\) 和 \(d_2\) 的两个 独立 卡方随机变量,则如下随机变量服从F分布。

F分布的概率密度函数有两个参数 \(d_1\) 和 \(d_2\) ,记作 \(F(d_1,d_2)\) 。 F分布的期望值为

它的方差是

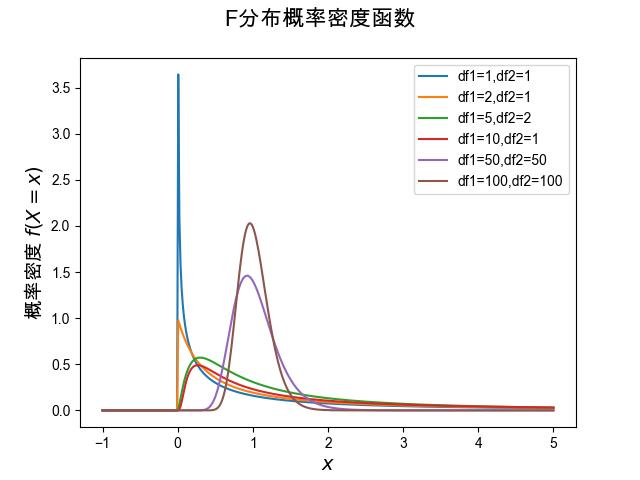

图 1.8.10 是F分布的概率密度函数曲线, 可以看出随着 \(d_1,d_2\) 的增加,F分布会变成一个类似正态分布的曲线, 并且越来越尖锐。

图 1.8.10 F分布的概率密度¶

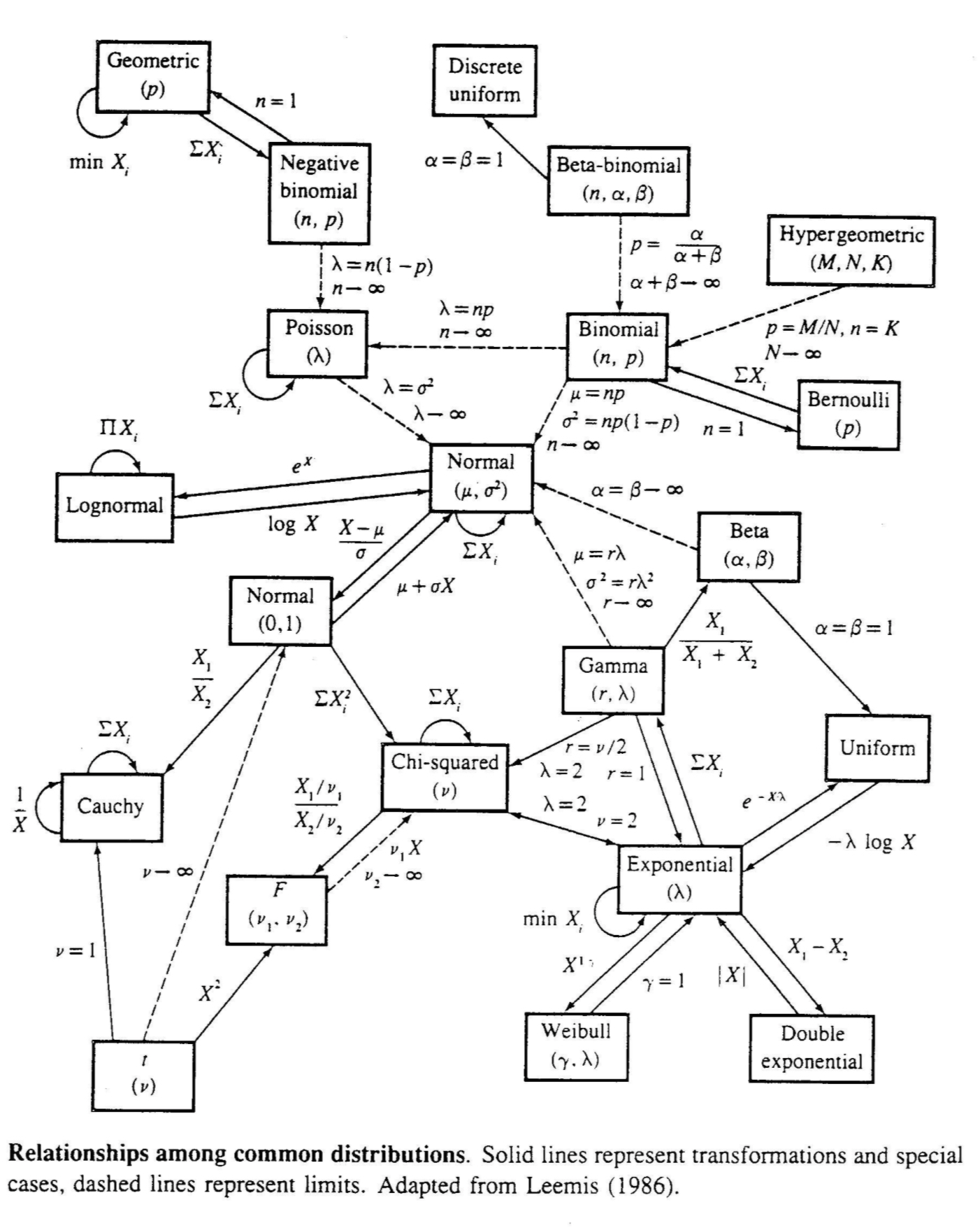

到这里我们发现无论是卡方分布、t分布、F分布都和正态分布有关系, 实际上,大部分概率分布都是和正态分布有关系的, 本章最后,我们给出一张图(图 1.8.11)来直观感受一下。

图 1.8.11 概率分布之间的关系图¶